EU AI Act: Was ändert sich im August 2025 und wie können Sie sich vorbereiten?

Am 2. August 2025 tritt ein wichtiger Teil des EU AI Act (EU-Gesetz über künstliche Intelligenz) in Kraft. Dies hat erhebliche Auswirkungen darauf, wie Sie Incidents im Zusammenhang mit künstlicher Intelligenz handhaben müssen.

Während die vollständige Verordnung erst ab 2026 gilt, gibt es ab diesem Sommer neue Pflichten für Anbieter von General Purpose AI (GPAI)-Modellen. Wenn Sie KI-basierte Dienste in Europa entwickeln oder bereitstellen, läuft Ihnen die Zeit davon.

Die gute Nachricht ist: Wenn Sie bereits mit einem strukturierten Incident-Response-Prozess arbeiten, sind Sie besser vorbereitet, als Sie eventuell denken. Um jedoch gesetzeskonform zu bleiben und Strafen zu vermeiden, sind einige wichtige Anpassungen erforderlich – etwa bei der Erkennung, Dokumentation und internen Kommunikation von Incidents.

In diesem Blogartikel erfahren Sie:

- Was sich im August 2025 genau ändert.

- Wie strukturierte Incident-Response in den Zeitplan des EU AI Acts passt.

- Was die Pflichten für Hochrisiko- und General-Purpose-KI tatsächlich bedeuten.

- Und wie ilert Teams dabei hilft, alle gesetzlichen Anforderungen zu erfüllen.

Was ist der EU AI Act und für wen gilt er?

Der EU AI Act ist das weltweit erste umfassende Regelwerk für künstliche Intelligenz. Ziel ist es, sicherzustellen, dass KI-Systeme in der Europäischen Union sicher, transparent und grundrechtskonform eingesetzt werden.

Die 2024 verabschiedete Verordnung verfolgt einen risikobasierten Ansatz und teilt KI-Systeme in vier Kategorien ein: inakzeptables, hohes, begrenztes und minimales Risiko – mit spezifischen Anforderungen für jede Kategorie.

Die Verordnung gilt für eine breite Palette von Akteuren in der KI-Wertschöpfungskette, darunter:

- Anbieter von KI-Systemen (Entwickler oder Betreiber)

- Betreiber (Organisationen, die KI-Systeme nutzen)

- Importeure und Distributoren von KI-Technologien

- Sogar einige nachgelagerte Nutzer in der EU – unabhängig davon, ob der Anbieter in der EU ansässig ist oder nicht

Mit anderen Worten: Wenn Ihr Unternehmen KI-gestützte Dienste in der EU anbietet oder betreibt, insbesondere in Bereichen, die als „hochriskant“ gelten (z. B. Recruiting, Gesundheitswesen oder Finanzen), sind Sie wahrscheinlich zur Einhaltung der Vorschriften verpflichtet.

Um dies festzustellen, beurteilen Sie, ob Ihr KI-System laut Risikokategorien des Gesetzes Auswirkungen auf Sicherheit, Rechte oder kritische Dienste hat.

Der AI Act betrifft auch Entwickler von General-Purpose-AI-Modellen (GPAI) wie LLMs. Ab August 2025 müssen diese Anbieter neue Anforderungen an Transparenz, Dokumentation und Risikominderung erfüllen.

Was ändert sich ab August 2025?

Ab dem 2. August 2025 gelten neue Regeln für Anbieter von General-Purpose-AI-Modellen (GPAI), zu denen auch Large Language Modelle (LLMs) zählen.

Laut Europäischer Kommission müssen GPAI-Anbieter folgende Anforderungen erfüllen:

- Transparenz: Nutzer müssen explizit informiert werden, wenn Inhalte durch ein KI-System generiert wurden.

- Datenoffenlegung: Veröffentlichung einer Zusammenfassung der Trainingsdatenquellen und -verarbeitungsmethoden.

- Risikominderung: Bewertung und Reduzierung systemischer Risiken leistungsfähiger KI-Modelle.

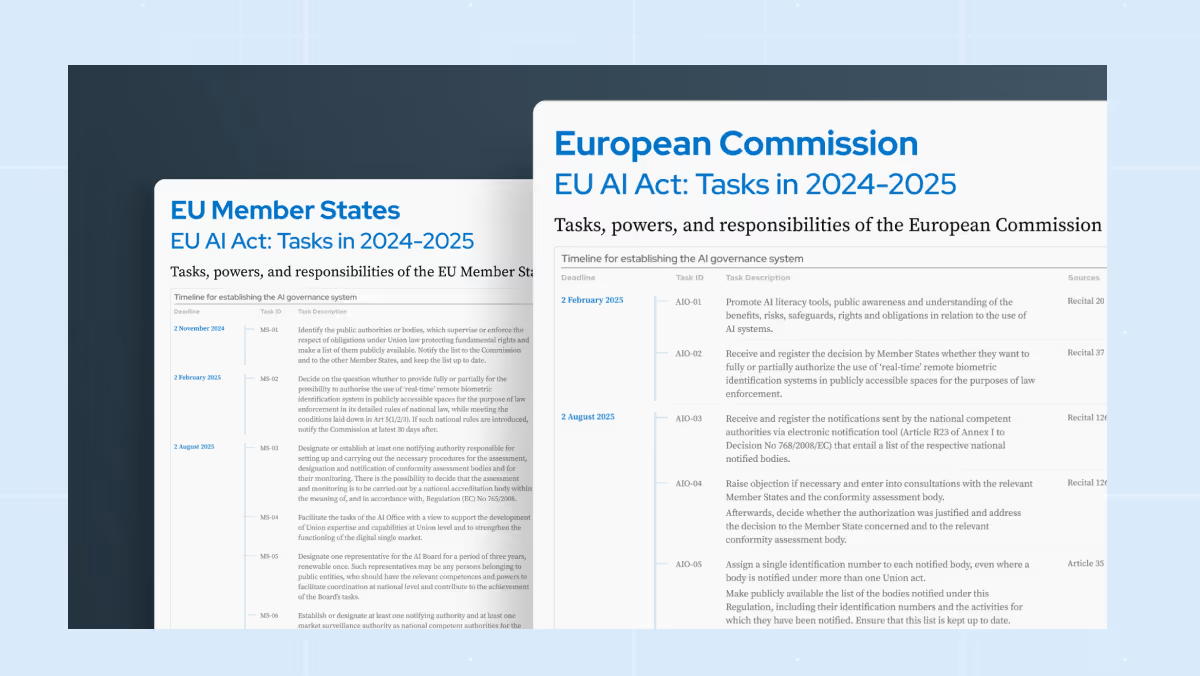

Welche Pflichten gelten bereits?

Seit dem 2. Februar 2025 sind bereits zwei wichtige Pflichten in Kraft getreten:

1. Verbotene KI-Praktiken (inakzeptables Risiko)

Der AI Act verbietet bestimmte KI-Systeme, die als inakzeptables Risiko für Sicherheit, Menschenrechte oder demokratische Werte gelten. Dazu gehören:

- Social Scoring durch Behörden

- Echtzeit-Biometrie-Erkennung (z. B. Gesichtserkennung im öffentlichen Raum)

- KI-Systeme, die Verhalten manipulieren oder Schwachstellen ausnutzen

- Emotionserkennung am Arbeitsplatz oder in Bildungseinrichtungen

- Predictive Policing auf Basis von Profiling oder früheren Straftaten

- Ungezieltes Scraping von Bildern oder Videos zur Erstellung biometrischer Datenbanken

2. Anforderungen an die KI-Kompetenz

Die Verordnung führt auch Anforderungen an die KI-Kompetenz für Anbieter und Betreiber ein, darunter:

- Sicherstellen, dass Nutzer und Überwacher von KI-Systemen verstehen, wie das System funktioniert

- Erkennen von Vorurteilen, Risiken und Grenzen

- Wissen, wie man überwacht und im Bedarfsfall eingreift

Diese Regeln sollen das Bewusstsein und die sichere Nutzung von KI branchenübergreifend stärken – noch bevor für Hochrisiko-Systeme 2026 strengere Regeln gelten.

Welche Rolle spielt Incident-Management bei der EU AI Act Compliance?

Die Compliance mit dem EU AI Act konzentriert sich auf fünf operative Pflichten. Wir haben jede Pflicht dem entsprechenden Artikel der Verordnung zugeordnet und mit einem klaren nächsten Schritt für Incident-Response-Teams ergänzt.

Automatische Ereignisprotokolle (Artikel 12)

Anbieter von Hochrisiko-KI müssen manipulationssichere Protokolle führen, sodass Behörden das Systemverhalten rekonstruieren können.

Das sollten Sie tun: Aktivieren Sie maschinell erzeugte Timelines, die jede Alarmierung, jede Eskalation, jedes Rollback und jede Maßnahme erfassen, und exportieren Sie diese Protokolle im regulatorisch geforderten Format.

72-Stunden-Benachrichtigung (Artikel 73)

Schwere Incidents oder Fehlfunktionen müssen innerhalb von 72 Stunden nach Bekanntwerden gemeldet werden.

Das sollten Sie tun: Verwenden Sie Playbooks, die gleichzeitig die Technik-, Rechts- und Kommunikationsabteilungen benachrichtigen, damit die Berichterstattung beginnen kann, während der Incident noch aktiv ist.

Funktionsübergreifende Transparenz in Echtzeit (Artikel 73 §4)

Die Aufsichtsbehörden erwarten klare Rollen und Verantwortlichkeiten während eines Incidents.

Das sollten Sie tun: Geben Sie den Abteilungen Recht, Sicherheit und Geschäftsleitung in Echtzeit Zugriff auf die Timeline des Incidents und stellen Sie kontrollierte Statusaktualisierungen bereit, damit externe Stakeholder ohne zusätzliche Meetings verifizierte Informationen erhalten.

Automatisierte Nachweisführung nach Incidents (Artikel 73 §4)

Protokolle müssen zur Überprüfung gespeichert werden und müssen Beschreibung, Auswirkungen, Korrekturmaßnahmen sowie betroffene Parteien enthalten.

Das sollten Sie tun: Erstellen Sie automatisch aus der Live-Timeline einen Post-Incident-Report, ergänzen Sie eine Impact-Analyse und Follow-up-Maßnahmen, sodass jeder Bericht dieselben Compliance-Felder enthält.

Kontinuierliche Risikominderung für GPAI (Artikel 55)

Anbieter von General-Purpose-KI-Modellen müssen systemische Risiken kontinuierlich bewerten und mindern.

Das sollten Sie tun: Integrieren Sie Monitoring-Signale wie Abweichungen der Modellausgabe oder Spitzen bei Inferenzfehlern, sodass bei Überschreiten der Schwellenwerte automatisch ein Incident eröffnet und die oben genannten Schritte ausgelöst werden.

Da der AI Act Grundsätze mit DSGVO, NIS2 und DORA teilt, können Sie mit rechtzeitigen Benachrichtigungen, transparenter Dokumentation und klarer Verantwortlichkeit sowie der Erfassung aller Incident-Daten in einem Workflow gleich mehrere Regularien mit demselben Nachweissatz erfüllen.

Wie ilert diese Anforderungen erfüllt

- Automatische Protokollierung – Jede Alarmierung, jede Eskalation und jede Reaktion wird in einer manipulationssicheren Timeline gespeichert, die Sie exportieren können.

- Schnelle Benachrichtigung – Multi-Channel-Alerting und Playbooks benachrichtigen IT-, Rechts- und Kommunikationsabteilungen gleichzeitig und unterstützen Sie so bei der Einhaltung der 72-Stunden-Regel.

- Bereichsübergreifende Transparenz – Rollenbasierte Ansichten und Statusseiten halten Sicherheits- und Führungskräfte informiert – ohne Extra-Meetings.

- Nachweisführung nach Incidents – Mit einem Klick wird die Live-Timeline in ein prüfbereites Postmortem mit Impact, Maßnahmen und Follow-ups umgewandelt.

.avif)

Fazit

Der EU AI Act ist nicht nur eine weitere Compliance-Pflicht. Er signalisiert, dass Organisationen ihr Risikomanagement in einer KI-gestützten Welt neu denken müssen. Für Unternehmen, die Hochrisiko-KI-Systeme entwickeln oder betreiben, sind starke Incident-Response-Praktiken nicht mehr optional, sondern essenziell.

Ganz gleich, ob Sie sich auf die Anforderungen ab August 2025 vorbereiten oder auf den vollständigen Rollout 2026: Entscheidend ist, Compliance in Ihre operativen Workflows zu integrieren – und nicht nachträglich nachzurüsten. Mit Tools wie ilert ist vieles davon bereits möglich: vollautomatisiertes Alerting und Eskalation, abteilungsübergreifende Koordination, Echtzeit-Dokumentation und prüfbereite Postmortems.

Das Beste daran? Wenn Incident Response richtig gemacht wird, wird Compliance zum natürlichen Nebenprodukt – und nicht zur Belastung.

Kurzfassung

Der EU AI Act bringt strenge Meldepflichten bei Incidents, einige Regeln sind bereits ab Februar 2025 aktiv. Ab August 2025 müssen Anbieter von General-Purpose-KI-Modellen neue Anforderungen in Bezug auf Transparenz, Sicherheit und Urheberrecht erfüllen.

Mit Artikel 73 und der 72-Stunden-Meldepflicht für Hochrisiko-Incidents ist ein strukturierter, automatisierter Incident-Response-Prozess der effizienteste Weg zur Compliance. ilert unterstützt Teams dabei, Incidents in Echtzeit zu dokumentieren, bereichsübergreifende Zusammenarbeit zu optimieren und den Aufwand für regulatorische Berichterstattung zu reduzieren.