Was bedeutet Data Aggregation?

Unter Datenaggregation versteht man den strukturierten Prozess, bei dem Rohdaten aus mehreren Quellen gesammelt, kombiniert und in einheitliche, analysierbare Formate überführt werden. In diesem Artikel erklären wir die Bedeutung von Datenaggregation für SRE-, DevOps- und Incident-Management-Workflows – insbesondere vor dem Hintergrund, dass Observability und KI-gesteuerte Betriebsabläufe ab 2025 zur Norm werden.

Definition & technische Grundlagen

Datenaggregation bedeutet, dass Rohdaten aus verschiedenen Quellen – zum Beispiel Datenbanken, Logs, Metriken und Telemetrie – erfasst und in aggregierte Kennzahlen wie Summen, Durchschnitte, Minima, Maxima oder andere aggregierte Statistiken transformiert werden. Technisch geschieht dies häufig mithilfe von Aggregatfunktionen (SUM, COUNT, AVG, MAX, MIN, MEDIAN usw.) in Datenbanken oder Abfrage-Engines.

Moderne Datenaggregation geht über einfache Zusammenfassungen hinaus: Sie zielt auf Schema-Harmonisierung, Zeitstempel-Normierung, Erkennung von Duplikaten und Nachverfolgung der Datenherkunft, um sicherzustellen, dass aggregierte Datensätze verlässlich und abfragebereit sind. Typische Workflows umfassen:

- Erfassung – Abruf von Daten aus unterschiedlichen Quellen (z. B. APIs, Log-Streams)

- Standardisierung – Normierung von Feldnamen, Formaten und Zeitstempeln

- Deduplizierung – Entfernung redundanter Datensätze

- Gruppierung und Zusammenfassung – Überführung der Daten in sinnvolle Aggregationen

- Validierung und Datenherkunft – Sicherstellung von Schema-Integrität und Rückverfolgbarkeit

Anwendungsfälle in SRE, DevOps & Incident-Management

Aggregation von Observability- & Telemetrie-Daten

SRE-Teams nutzen aggregierte Telemetriedaten – also die Kombination aus Metriken, Logs und Traces – zur Erstellung von Observability-Dashboards. Datenaggregation ermöglicht Trendanalysen, Erkennung von Anomalien (Anomaly Detection) und Ursachenanalysen, indem sie komplexe Telemetriedaten in auswertbare Formate überführt.

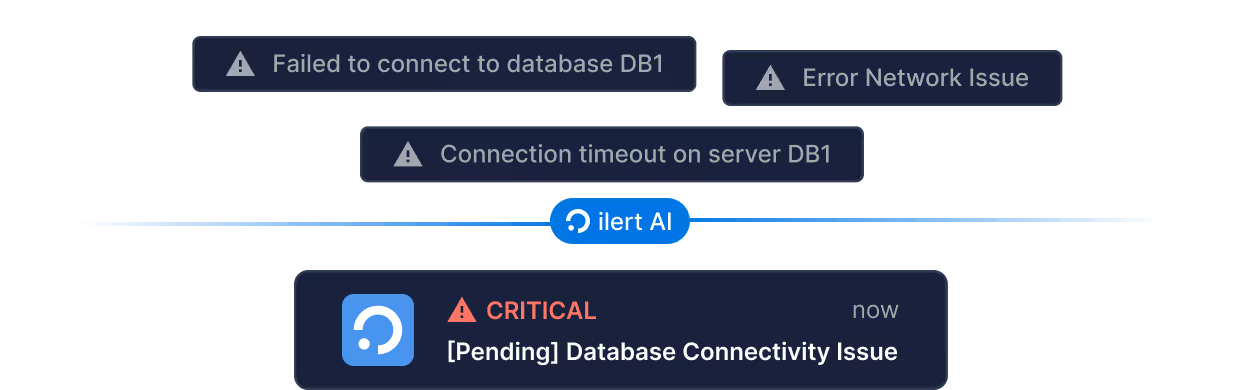

Deduplizierung von Alarmierungen & Verringerung der Alarmflut

In modernen Incident-Management-Systemen wie ilert hilft fortschrittliche Aggregation dabei, Hunderte oder Tausende von Events – insbesondere bei kaskadierenden Ausfällen – in wenige aussagekräftige Alarmierungen zu konsolidieren. Das hilft dabei, Alarmmüdigkeit zu verringern und steigert die Effizienz der Incident-Responder.

KI-gesteuerte Incident-Erkennung

AIOps-Plattformen aggregieren Daten in großem Umfang, um Anomalien zu erkennen, Incidents vorherzusagen und automatisierte Gegenmaßnahmen einzuleiten. Zukunftssichere AIOps-Frameworks vereinen Datenquellen und nutzen Machine Learning zur Steuerung des gesamten Incident Response Lebenszyklus.

Echtzeit- vs. Batch-Aggregation in moderner Observability

Datenaggregation erfolgt in zwei Hauptmodi: Batch und Echtzeit. Batch-Aggregation verarbeitet Daten in geplanten Intervallen – meist stündlich oder täglich – zur Erstellung von Reports, Business-Intelligence-Dashboards oder SLA-Auswertungen. Dieser Modus eignet sich besonders für retrospektive Analysen und Audits, bei denen Stabilität und Konsistenz wichtig sind.

Bei der Echtzeitaggregation hingegen werden Daten kontinuierlich verarbeitet, sobald sie eintreffen. Auswertungen werden nahezu sofort geliefert – was überaus wichtig ist für Live-Dashboards, die Erkennung von Anomalien und automatisch ausgelöste Workflows im DevOps-Umfeld. Viele Unternehmen kombinieren beide Ansätze: Batch für langfristige Analysen und Compliance, Echtzeit für operatives Monitoring und Incident Response.

Trends 2025: So verändert sich Datenaggregation in der Incident Response

KI und Machine Learning revolutionieren die Incident Response, indem sie prädiktive Analysen, automatisierte Anomalieerkennung und intelligente Ursachenanalysen ermöglichen. Diese Entwicklung erlaubt SRE- und DevOps-Teams, vom reaktiven Incident-Handling zu einer proaktiven Resilienz-Strategie zu wechseln – mit Datenaggregation als zentrale Grundlage.

Die zunehmende Verbreitung offener Standards wie OpenTelemetry (OTEL) erleichtert die Aggregation unterschiedlicher Telemetrietypen – Metriken, Logs und Traces – durch vereinheitlichte Schemata und herstellerneutrale Formate. OTEL ermöglicht konsistente, interoperable Observability-Pipelines, die sich leichter warten und skalieren lassen.

Ein weiterer Trend ist die Konvergenz von Observability und Security. Moderne Incident-Workflows integrieren Betriebs- und Sicherheitsdaten zu einem einheitlichen Incident-Verlauf. Die gemeinsame Aggregation dieser Daten verbessert die Erkennung von Bedrohungen und liefert umfassendere Erkenntnisse, was zu schnelleren und effektiveren Reaktionen führt.

Best Practices für Engineers

- Schema und Versionierung durchsetzen – Vermeiden Sie fehlerhafte Aggregation durch klare Definition und Versionierung von Schemata

- Rückverfolgbarkeit sicherstellen – Jede Aggregation sollte auf ihre Quelle zurückführbar sein

- Batch und Echtzeit kombinieren – Optimieren Sie Stabilität und Reaktionsgeschwindigkeit zugleich

- KI gezielt einsetzen – Nutzen Sie Anomalieerkennung und prädiktive Aggregation, um Trends frühzeitig zu erkennen

- Offene Standards nutzen – Formate wie OTEL ermöglichen toolübergreifende skalierbare Aggregation

ilert Observability-Integrationen

Moderne Observability-Tools wie Prometheus, Datadog, Grafana, New Relic, AWS CloudWatch und Elastic setzen stark auf Datenaggregation, um Telemetrie-Rohdaten in verwertbare Erkenntnisse umzuwandeln. Metriken werden zu Trends aggregiert, Logs zu Mustern zusammengefasst, Traces zu End-to-End-Service-Maps komprimiert. Diese Tools verarbeiten riesige Eventströme, erzeugen jedoch bei Incidents häufig redundante oder sich überschneidende Alarmierungen.

Hier setzt ilert an: Durch direkte Integrationen mit diesen Tools fügt ilert eine zusätzliche Schicht intelligenter Ereignisaggregation und -korrelation hinzu. Statt jedes einzelne Signal weiterzuleiten, konsolidiert ilert verwandte Events zu einer einzigen, handlungsrelevanten Alarmierung.

Fazit

Datenaggregation ist eine grundlegende Technik im modernen IT-Betrieb – sie verwandelt Telemetrie-Rohdaten und Events in strukturierte Informationen, die SRE- und DevOps-Teams handlungsfähig machen. In einer zunehmend komplexen Systemlandschaft ist effektive Aggregation – schema-basiert, in Echtzeit, KI-gestützt und sicherheitsbewusst – im Jahr 2025 unverzichtbar für schnelle Incident Response und nachhaltige Betriebsstabilität.